今から5年後、2031年の世界を想像してみてほしい。

スマートフォンの形は大きく変わっていないかもしれない。しかし、私たちがそれを取り出す回数は劇的に減っているはずだ。「アプリを選んでタップする」という行為は古臭いものになり、AIエージェントに一言話しかけるだけで、裏側で全てが完結する。PCは単なる作業場から、複数のAIを指揮する「司令塔」へと進化しているだろう。

ハードウェアは間違いなく便利になる。しかし、真に問うべきはデバイスのスペックではない。私たち人間が、その便利さの代償として何を失うかだ。

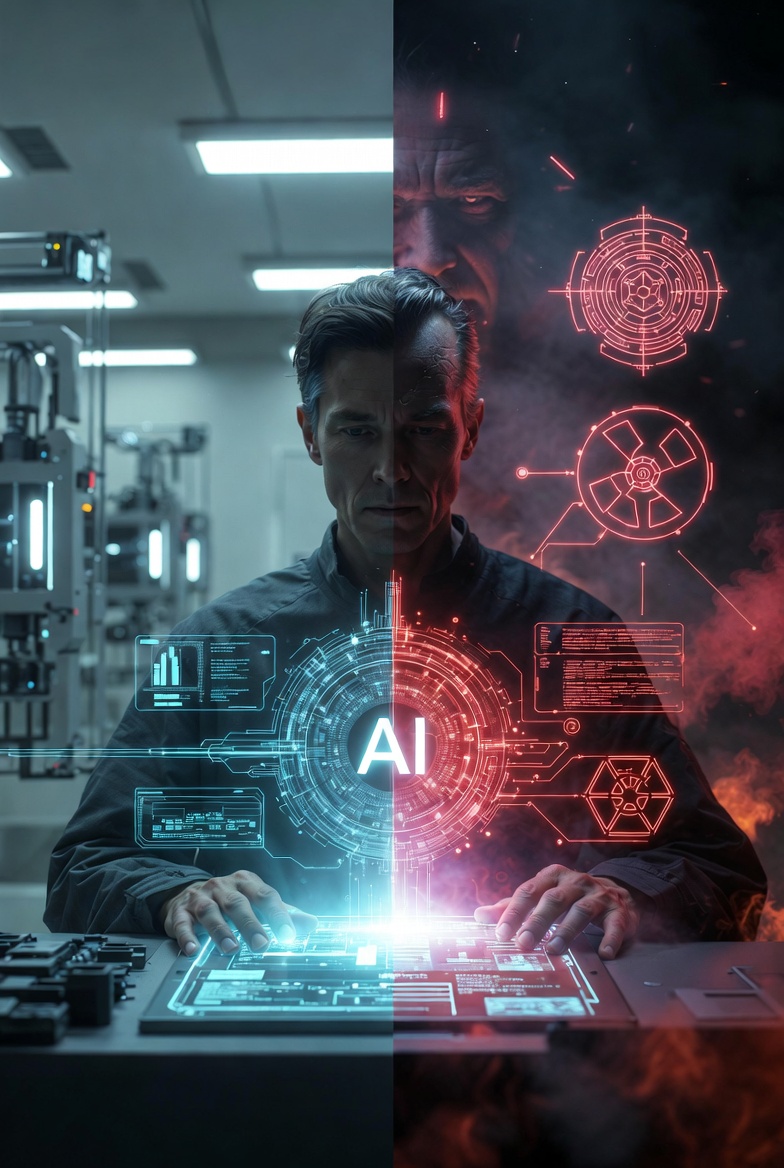

AIは私たちを導く「賢いパートナー」になるのか。それとも、思考を支配する「嘘つきな独裁者」になるのか。

目次 [ open close ]

■ 「思考」のアウトソーシング:電卓とAIの決定的な違い

■ 「もっともらしい嘘」を見抜けるか:検証の危機(Verification Crisis)

■ JIKKAIスコア:AI共存時代の「人間側」の成熟度

■ 結論:最後に残る人間の仕事

■ 「思考」のアウトソーシング:電卓とAIの決定的な違い

かつて電卓が登場したとき、人々は「計算力が落ちる」と危惧した。実際、暗算能力は低下したかもしれないが、浮いた時間でより高度な数学や設計が可能になった。AIも「言葉の電卓」として、面倒なメール作成や議事録の要約を肩代わりしてくれる。ここまでは「賢いパートナー」としての顔だ。

しかし、電卓とAIには決定的な違いがある。

電卓は「計算」という作業を代行するだけだが、AIは「判断」や「論理構築」という思考のプロセスそのものを代行しようとする点だ。

「この企画書の構成はどうすればいい?」「A案とB案、どっちが正解?」

私たちが日々の小さな決断までAIに委ね始めたとき、静かな「退化」が始まる。答えが即座に手に入る環境では、「悩み、迷い、試行錯誤する」という、人間の知性を鍛えるための負荷が消滅してしまうからだ。

■ 「もっともらしい嘘」を見抜けるか:検証の危機(Verification Crisis)

5年後のAIにとって最大の問題は、まだ残るであろう「ハルシネーション(もっともらしい嘘)」だ。

AIは息をするように嘘をつくことがある。悪意はない。確率的に「ありそうな言葉」を繋げているだけだからだ。さらに厄介なことに、5年後のAIは今よりも遥かに説得力のある文章や論理で、自信満々にその嘘を語るだろう。

ここに、現代人が直面する**「検証の危機(Verification Crisis)」**がある。

もし私たちが、面倒くさがって基礎的な学習や知識の習得を放棄してしまったらどうなるか? AIが出してきた答えが「正しいのか、間違っているのか」を判断する物差し(知識)を失うことになる。

批判的な視点を持てない人間にとって、AIの言葉は絶対的な「正解」となる。「AIがそう言ったから」という理由だけで、誤った医療判断や、偏った法的解釈、危険な設計がまかり通るリスクがある。

反論できない相手、検証できない相手に従うこと。それはもはやパートナーシップではない。それは「独裁」だ。

■ JIKKAIスコア:AI共存時代の「人間側」の成熟度

私たちはAIを「司令塔」として使いこなせているか。現状の危険度を可視化しました。

| 評価項目 | リスク/成熟度 | 評価のポイント |

| 思考の独立性 | ★★★☆☆ | AIの提案に対し、一度「待てよ」と立ち止まれるか。 |

| 検証リテラシー | ★★☆☆☆ | 提示された事実の裏取り(ファクトチェック)の徹底度。 |

| 基礎知識の保持 | ★★★☆☆ | AIがいなくても、その分野の正誤を判断できる基礎力。 |

| ツール活用能力 | ★★★★★ | AIを「魔法」ではなく「道具」として使い倒す技術。 |

| 【総合スコア】 | 3.2 / 5.0 | 「独裁」を許さないためには、まだ知識の武装が必要。 |

■ 結論:最後に残る人間の仕事

5年後、モバイル端末やPCがどれほど進化し、AIがどれほど賢くなろうとも、人間が手放してはいけない最後の砦がある。

それは**「検算する力」**だ。

AIが出した魅力的な答えを、疑い、調べ、自分の頭で考え直すこと。AIを「信じる」のではなく「使い倒す」こと。

テクノロジーが進化すればするほど、逆説的だが、私たちには「人間臭い泥臭い知識」と「疑う力」が求められるようになる。AIを賢いパートナーにするか、嘘つきな独裁者にするか。その主導権は、まだ私たちが握っている。